C++基于OpenCV实现手势识别的源码

时间:2022-12-06先给大家上效果图:

源码在下面

使用 RGB 值分割手部区域,即手部的 GB 值将与背景不同

或者使用边缘检测

或者

背景减法。

我这里使用了背景减法模型。OpenCV为我们提供了不同的背景减法模型,codebook 它的作用是对某些帧进行一段时间的精确校准。其中对于它获取的所有图像;它计算每个像素的平均值和偏差,并相应地指定框。

在前景中它就像一个黑白图像,只有手是白色的

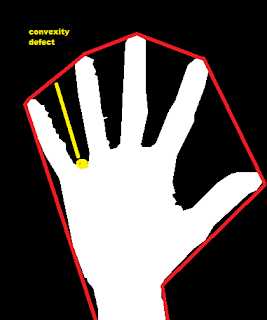

用 Convex Hull 来找到指尖。Convex hull 基本上是包围手部区域的凸集。

包围手的红线是凸包。基本上它是一个凸起;如果我们在红色区域内取任意两点并将它们连接起来形成一条线,那么这条线就完全位于集合内。

黄点是缺陷点,会有很多这样的缺陷点,即每个谷都有一个缺陷点。现在根据缺陷点的数量,我们可以计算展开的手指数量。

大概就是

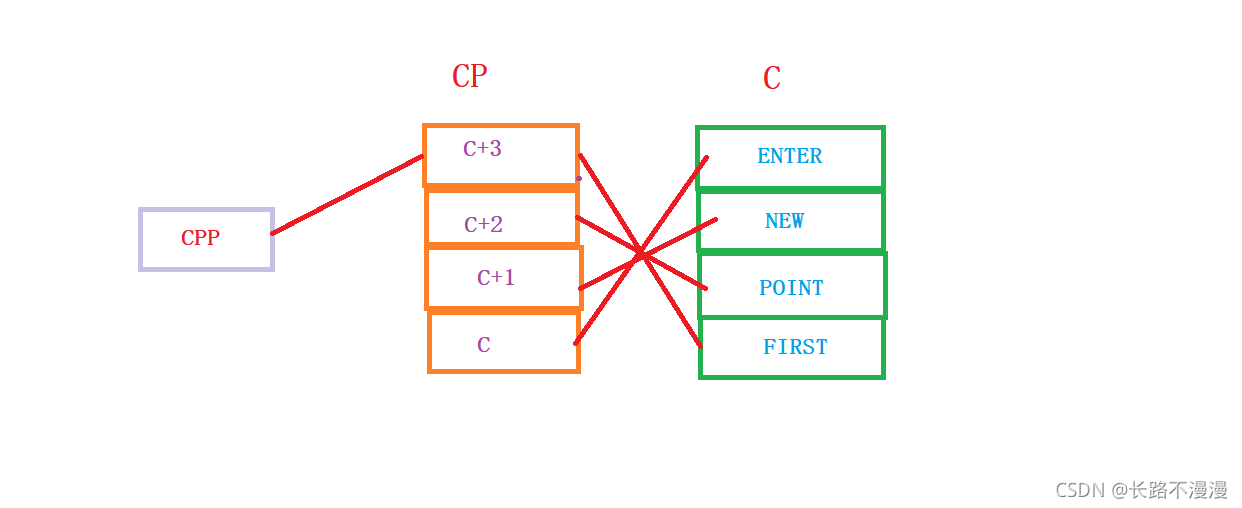

手部区域提取是使用背景减法完成的。

对于尖端点,深度点凸度缺陷。

提取轮廓和检测凸点的主要代码在函数中

无效检测(IplImage* img_8uc1,IplImage* img_8uc3);

将相机放在稳定的背景前;运行代码,等待一段时间。校准完成后。你会看到显示一些干扰的连接组件图像。把你的手放在相机视图中。

没什么好说的直接看代码会比较容易理解

核心代码

int main(int argc, char** argv)

{

const char* filename = 0;

IplImage* rawImage = 0, *yuvImage = 0;

IplImage *ImaskCodeBook = 0,*ImaskCodeBookCC = 0;

CvCapture* capture = 0;

int c, n, nframes = 0;

int nframesToLearnBG = 300;

model = cvCreateBGCodeBookModel();

model->modMin[0] = 3;

model->modMin[1] = model->modMin[2] = 3;

model->modMax[0] = 10;

model->modMax[1] = model->modMax[2] = 10;

model->cbBounds[0] = model->cbBounds[1] = model->cbBounds[2] = 10;

bool pause = false;

bool singlestep = false;

for( n = 1; n < argc; n++ )

{

static const char* nframesOpt = "--nframes=";

if( strncmp(argv[n], nframesOpt, strlen(nframesOpt))==0 )

{

if( sscanf(argv[n] + strlen(nframesOpt), "%d", &nframesToLearnBG) == 0 )

{

help();

return -1;

}

}

else

filename = argv[n];

}

if( !filename )

{

printf("Capture from camera\n");

capture = cvCaptureFromCAM( 0 );

}

else

{

printf("Capture from file %s\n",filename);

capture = cvCreateFileCapture( filename );

}

if( !capture )

{

printf( "Can not initialize video capturing\n\n" );

help();

return -1;

}

for(;;)

{

if( !pause )

{

rawImage = cvQueryFrame( capture );

++nframes;

if(!rawImage)

break;

}

if( singlestep )

pause = true;

if( nframes == 1 && rawImage )

{

// CODEBOOK METHOD ALLOCATION

yuvImage = cvCloneImage(rawImage);

ImaskCodeBook = cvCreateImage( cvGetSize(rawImage), IPL_DEPTH_8U, 1 );

ImaskCodeBookCC = cvCreateImage( cvGetSize(rawImage), IPL_DEPTH_8U, 1 );

cvSet(ImaskCodeBook,cvScalar(255));

cvNamedWindow( "Raw", 1 );

cvNamedWindow( "ForegroundCodeBook",1);

cvNamedWindow( "CodeBook_ConnectComp",1);

}

if( rawImage )

{

cvCvtColor( rawImage, yuvImage, CV_BGR2YCrCb );

if( !pause && nframes-1 < nframesToLearnBG )

cvBGCodeBookUpdate( model, yuvImage );

if( nframes-1 == nframesToLearnBG )

cvBGCodeBookClearStale( model, model->t/2 );

if( nframes-1 >= nframesToLearnBG )

{

cvBGCodeBookDiff( model, yuvImage, ImaskCodeBook );

centers if desired

cvCopy(ImaskCodeBook,ImaskCodeBookCC);

cvSegmentFGMask( ImaskCodeBookCC );

cvShowImage( "CodeBook_ConnectComp",ImaskCodeBookCC);

detect(ImaskCodeBookCC,rawImage);

}

cvShowImage( "Raw", rawImage );

cvShowImage( "ForegroundCodeBook",ImaskCodeBook);

}

c = cvWaitKey(10)&0xFF;

c = tolower(c);

if(c == 27 || c == 'q')

break;

switch( c )

{

case 'h':

help();

break;

case 'p':

pause = !pause;

break;

case 's':

singlestep = !singlestep;

pause = false;

break;

case 'r':

pause = false;

singlestep = false;

break;

case ' ':

cvBGCodeBookClearStale( model, 0 );

nframes = 0;

break;

case 'y': case '0':

case 'u': case '1':

case 'v': case '2':

case 'a': case '3':

case 'b':

ch[0] = c == 'y' || c == '0' || c == 'a' || c == '3';

ch[1] = c == 'u' || c == '1' || c == 'a' || c == '3' || c == 'b';

ch[2] = c == 'v' || c == '2' || c == 'a' || c == '3' || c == 'b';

printf("CodeBook YUV Channels active: %d, %d, %d\n", ch[0], ch[1], ch[2] );

break;

case 'i':

case 'o':

case 'k':

case 'l':

{

uchar* ptr = c == 'i' || c == 'o' ? model->modMax : model->modMin;

for(n=0; n<NCHANNELS; n++)

{

if( ch[n] )

{

int v = ptr[n] + (c == 'i' || c == 'l' ? 1 : -1);

ptr[n] = CV_CAST_8U(v);

}

printf("%d,", ptr[n]);

}

printf(" CodeBook %s Side\n", c == 'i' || c == 'o' ? "High" : "Low" );

}

break;

}

}

cvReleaseCapture( &capture );

cvDestroyWindow( "Raw" );

cvDestroyWindow( "ForegroundCodeBook");

cvDestroyWindow( "CodeBook_ConnectComp");

return 0;

}要直接跑代码调试的,可以直接去下载

到此这篇关于C++基于OpenCV实现手势识别的源码的文章就介绍到这了,更多相关OpenCV手势识别内容请搜索html5模板网以前的文章希望大家以后多多支持html5模板网!

相关文章

浅谈C++ 设计模式的基本原则这篇文章主要介绍了++ 设计模式的基本原则,主要的目标是实现最终目的,高内聚,低耦合,开放封闭原则类的改动

浅谈C++ 设计模式的基本原则这篇文章主要介绍了++ 设计模式的基本原则,主要的目标是实现最终目的,高内聚,低耦合,开放封闭原则类的改动 一道面试题教你轻松玩转C++指针下面小编就为大家带来一篇深入理解c++指针的指针和指针的引用。小编觉得挺不错的,现在就分享给大家,也给大家

一道面试题教你轻松玩转C++指针下面小编就为大家带来一篇深入理解c++指针的指针和指针的引用。小编觉得挺不错的,现在就分享给大家,也给大家 一篇文章带你入门C++的异常处理C++ 提供了异常机制,让我们能够捕获运行时错误,本文就详细的介绍了C++异常处理入门,具有一定的参考价值,感兴

一篇文章带你入门C++的异常处理C++ 提供了异常机制,让我们能够捕获运行时错误,本文就详细的介绍了C++异常处理入门,具有一定的参考价值,感兴 C++内存模型和名称空间详解这篇文章主要给大家介绍了关于C/C++中的内存模型和名称空间详解,文中通过示例代码介绍的非常详细,对大家学习或

C++内存模型和名称空间详解这篇文章主要给大家介绍了关于C/C++中的内存模型和名称空间详解,文中通过示例代码介绍的非常详细,对大家学习或 利用c++写一个简单的推箱子小游戏推箱子想必是很多人童年时期的经典游戏,我们依旧能记得抱个老人机娱乐的场景,下面这篇文章主要给大家介绍了关于

利用c++写一个简单的推箱子小游戏推箱子想必是很多人童年时期的经典游戏,我们依旧能记得抱个老人机娱乐的场景,下面这篇文章主要给大家介绍了关于![C++中char[]能修改char*却不行](http://pic.html5code.net/allimg/221205/1C0234II01Z-13VV.png) C++中char[]能修改char*却不行本文主要介绍了C++中char[]能修改char*却不行,文中通过示例代码介绍的非常详细,具有一定的参考价值,感兴趣的小伙

C++中char[]能修改char*却不行本文主要介绍了C++中char[]能修改char*却不行,文中通过示例代码介绍的非常详细,具有一定的参考价值,感兴趣的小伙

C语言指针引用数组案例讲解这篇文章主要介绍了C语言指针引用数组案例讲解,本篇文章通过简要的案例,讲解了该项技术的了解与使用,以下就是详细内容

C语言指针引用数组案例讲解这篇文章主要介绍了C语言指针引用数组案例讲解,本篇文章通过简要的案例,讲解了该项技术的了解与使用,以下就是详细内容